Videollamadas y actas con IA

Cómo evitar filtraciones y usos indebidos cuando una reunión se graba, se transcribe y se “resume” en la nube.

Introducción

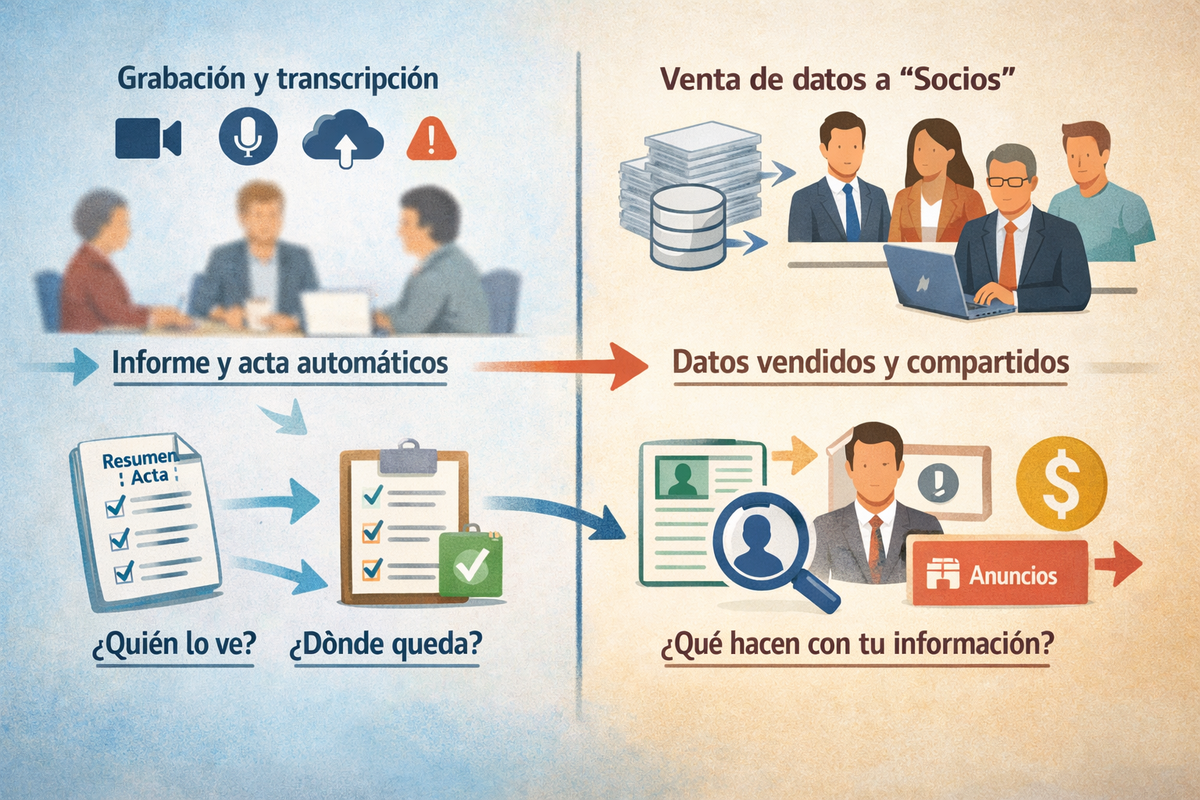

Las videollamadas ya no son solo “una reunión con cámara”. Cada vez es más habitual que se graben, se transcriban y que una herramienta de IA genere un resumen, tareas y actas automáticamente. Esto ahorra tiempo, pero también cambia la seguridad de la información: lo que antes quedaba entre quienes estaban conectados ahora puede convertirse en un fichero de audio/vídeo, un texto completo y un conjunto de metadatos procesados por proveedores externos.

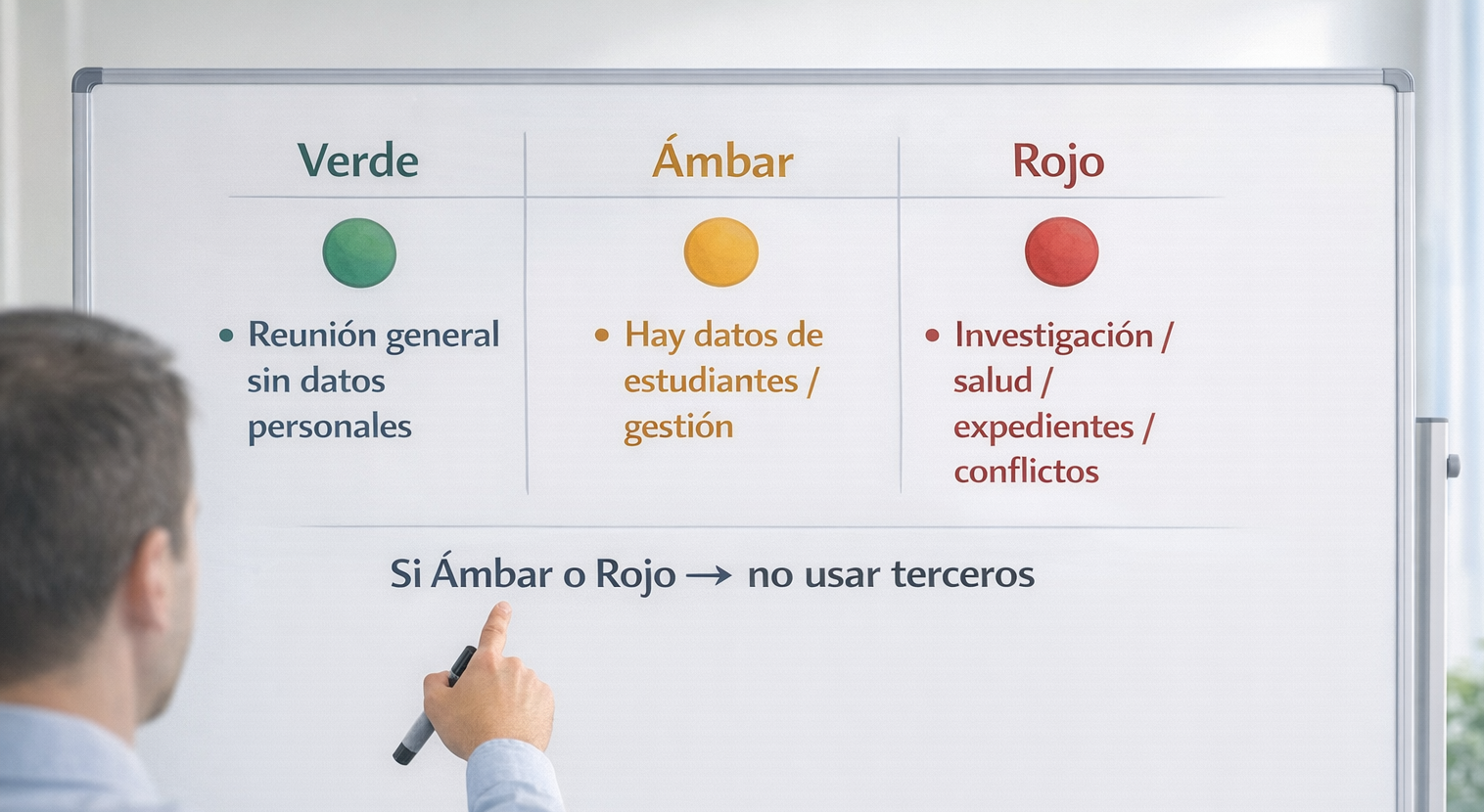

En un entorno universitario, además, la conversación suele mezclar datos personales (alumnado, PDI, PAS), decisiones académicas, información de investigación, temas de gestión y, a veces, información sensible por contexto (salud, becas, situaciones familiares, expedientes). Si esa información se envía a aplicaciones de terceros o “agentes” de IA en la nube sin evaluación previa, aparecen riesgos de confidencialidad, de cumplimiento del RGPD y de control real sobre quién accede a qué y dónde se almacena.

Qué es la transcripción y el “acta con IA” y por qué importa

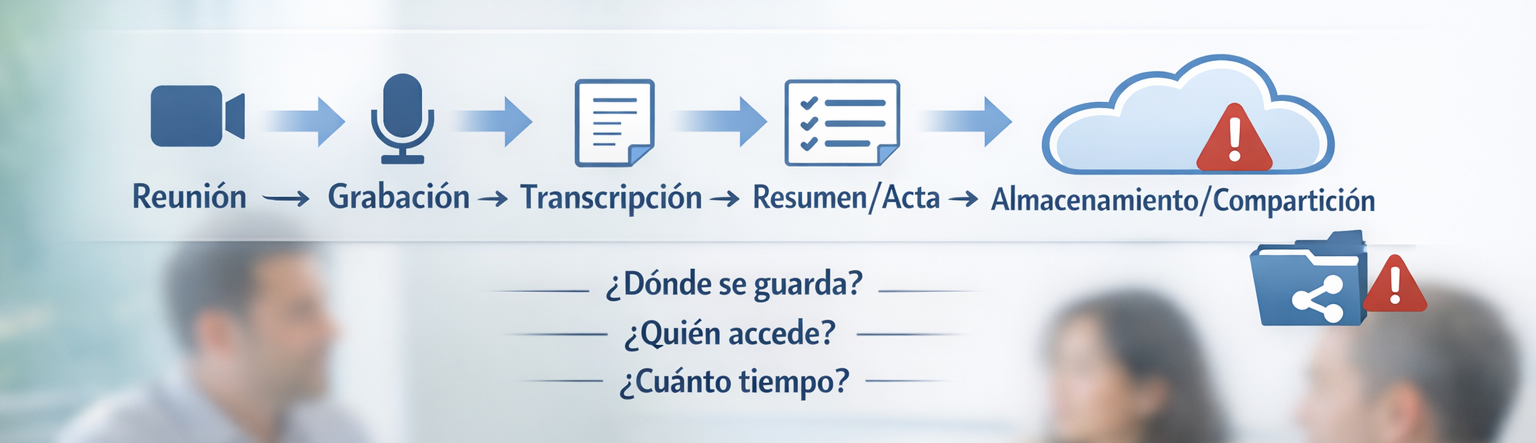

Cuando activas una función de “transcripción” o un asistente que “toma notas”, normalmente pasan varias cosas (a veces sin que sea evidente):

- Se captura audio (y a veces vídeo). Aunque la herramienta prometa “solo texto”, suele partir de un audio que se envía a un servicio para convertir voz en texto.

- Se genera un texto completo de la conversación. Esto puede incluir nombres, preguntas, dudas, acuerdos, información de estudiantes, contraseñas dichas en voz alta, números de expediente, etc.

- Un modelo de IA resume, etiqueta y extrae acciones. El “resumen” no es solo un documento: puede incluir temas, entidades (personas, asignaturas, proyectos) y decisiones.

- Se almacenan metadatos. Quién participó, cuándo, desde dónde, duración, y a veces el historial de ediciones y compartición.

La diferencia clave es que una conversación efímera se convierte en datos persistentes. Y eso multiplica el impacto si se comparte de más, si se conserva demasiado tiempo o si queda en manos de un proveedor que no cumple lo exigible para datos universitarios.

Qué se ve desde fuera: señales útiles y límites

Hay indicios que ayudan a detectar si una reunión está siendo capturada o “asistida” por una herramienta externa, pero ninguno es infalible. Lo útil es combinar señales:

- Aparece un “bot” o un participante extraño. Algunos servicios entran como un usuario más (“Recorder”, “Notetaker”, etc.). Ojo: el nombre puede ser genérico y no deja claro el proveedor real.

- Se anuncia “Grabando” o “Transcribiendo”. A veces se muestra un aviso, pero puede variar por plataforma y configuración.

- Llega un correo con enlace a “la transcripción” o “el resumen”. Si el enlace apunta a un servicio que no reconoces, es una señal clara de que los datos han salido a un tercero.

- Se piden permisos amplios. Algunas herramientas solicitan acceso al calendario, al correo o a ficheros “para funcionar mejor”. Es frecuente que pidan más de lo necesario.

Límites: que no veas un aviso no significa que no se esté guardando nada; y que haya aviso no garantiza que el almacenamiento sea adecuado ni que el proveedor cumpla el RGPD para el uso concreto.

Qué ocurre por dentro (sin jerga)

Para entender por qué estas herramientas elevan el riesgo, basta con tres ideas sencillas:

- De conversación a “fichero”. Cuando se graba o transcribe, se crean activos: audio/vídeo, texto y resumen. Eso requiere permisos, almacenamiento y, casi siempre, una cuenta o servicio donde quedan guardados.

- De “uso puntual” a “procesamiento”. Si un tercero convierte voz en texto y genera un acta, está tratando datos (a menudo personales). En términos de privacidad, eso exige base legal, garantías y un contrato adecuado (relación responsable/encargado y subencargados) [EDPB, 2021].

- De almacenamiento local a “nube y subproveedores”. El proveedor principal puede apoyarse en otros (infraestructura, analítica, modelos, soporte). Cada eslabón añade superficie de exposición y obligaciones de transparencia.

Qué está en juego en la Universidad

En una universidad, una reunión puede parecer “administrativa”, pero contener información que requiere cuidado. Ejemplos habituales:

- Expedientes y evaluación: actas, revisiones, adaptaciones, tutorías, incidencias de clase, prácticas.

- Gestión y personal: procesos de contratación, organización docente, situaciones personales, cambios de puesto, partes de trabajo.

- Movilidad y vida universitaria: documentación de estancias, visados, ayudas, becas, incidencias de alojamiento.

- Investigación y transferencia: borradores de propuestas, presupuestos, acuerdos con socios, resultados preliminares, propiedad intelectual.

- Servicios al estudiante: orientación, apoyo, situaciones delicadas por contexto.

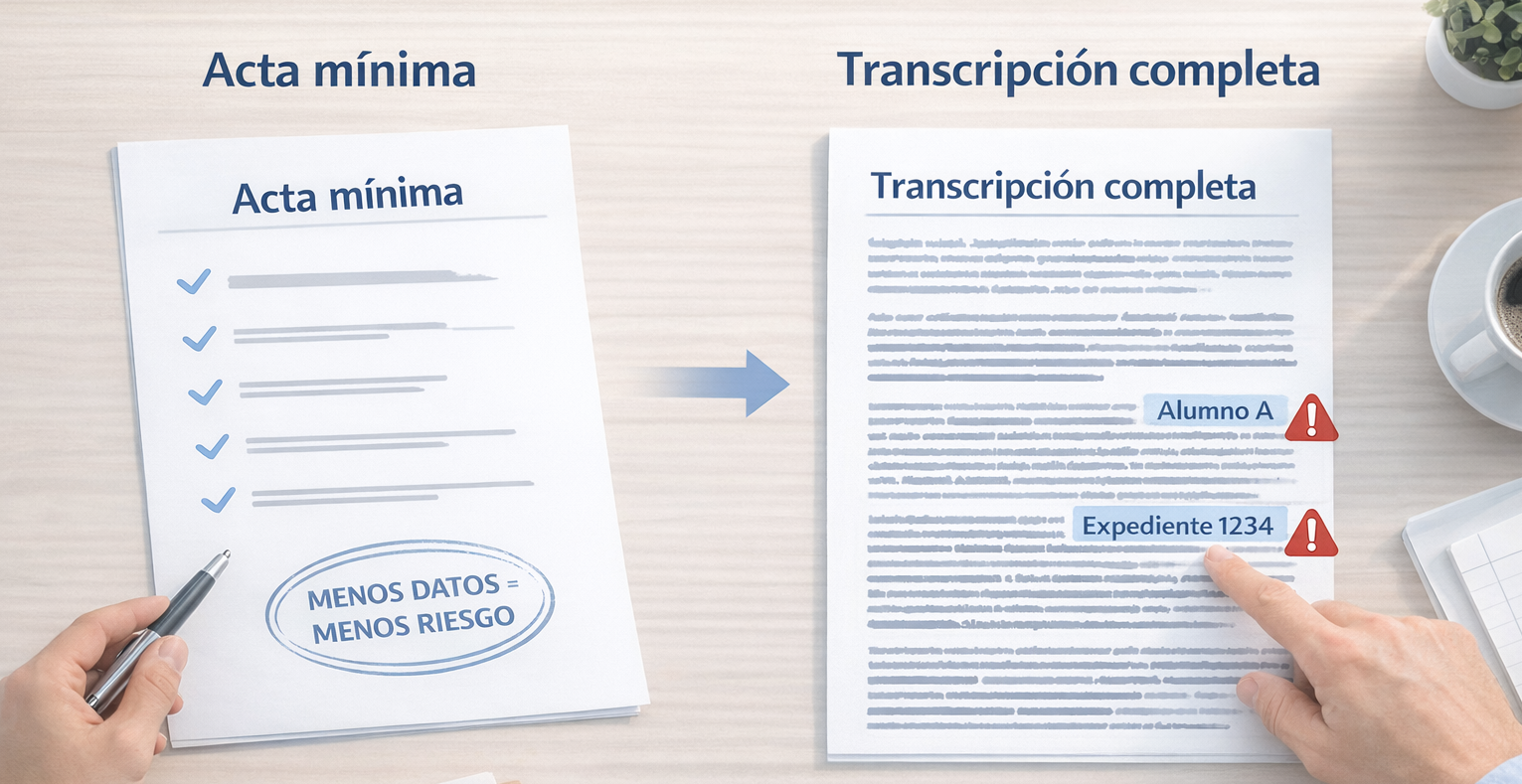

Cuando una herramienta externa genera “actas automáticas”, puede capturar más de lo que habrías escrito en un acta manual: frases textuales, opiniones, datos no necesarios o incluso información especialmente sensible por contexto. Además, un resumen puede circular mucho más rápido que una grabación, porque “parece inofensivo”.

Riesgos principales con la técnica “cebolla”

Riesgo 1: Fuga por compartición o enlaces.

Capa 1 (lo que ves): alguien reenvía el enlace del resumen o la transcripción “para que todos lo tengan” y termina llegando a quien no toca.

Capa 2 (en el sistema): el enlace puede estar abierto a “cualquiera con el enlace” o permitir indexación interna del proveedor; además, quedan copias en correos y en historiales de acceso.

Capa 3 (cómo ayuda el STIC): pautas de compartición mínima, revisión de permisos, contención si se ha compartido de más (retirar acceso, invalidar enlaces) y orientación para reportar cuanto antes.

Riesgo 2: Acceso por credenciales robadas o sesión comprometida.

Capa 1 (lo que ves): alguien entra a la cuenta donde se guardan actas y descarga transcripciones sin que nadie lo note.

Capa 2 (en el sistema): muchas intrusiones empiezan por credenciales robadas; cuando hay terceros implicados, el control de accesos, la detección y la respuesta se vuelven más complejos [Verizon, 2025].

Capa 3 (cómo ayuda el STIC): recomendaciones para reducir exposición (sesiones, dispositivos, permisos), y apoyo en la recuperación de cuentas y en la gestión de incidentes.

Riesgo 3: Transferencias internacionales de datos y RGPD.

Capa 1 (lo que ves): la herramienta “funciona” y entrega un resumen perfecto; no piensas dónde se ha procesado.

Capa 2 (en el sistema): el tratamiento puede implicar transferencias fuera del EEE/UE (almacenamiento, soporte, subprocesadores o acceso remoto). El RGPD exige cumplir condiciones estrictas del Capítulo V para transferencias a terceros países [AEPD, 2026; EDPB, 2025].

Capa 3 (cómo ayuda el STIC): criterios de uso y acompañamiento para canalizar alternativas autorizadas y evitar que datos universitarios se procesen en entornos no evaluados.

Riesgo 4: “Gratis” a cambio de datos (confidencialidad y usos no previstos).

Capa 1 (lo que ves): una app gratuita promete actas automáticas y “productividad”.

Capa 2 (en el sistema): algunos modelos de negocio dependen de recoger telemetría, analítica, metadatos o incluso contenido para mejorar el servicio o monetizarlo. Aunque no siempre sea “venta” literal, puede ser incompatible con el uso universitario si no hay garantías y contrato.

Capa 3 (cómo ayuda el STIC): evaluación previa de proveedores, orientación sobre qué categorías de información no deben salir a terceros y alternativas institucionales.

Cómo ayuda el STIC

En estos temas, el valor no está en “prohibir por prohibir”, sino en proteger a las personas y a la Universidad con reglas claras y realistas. El STIC puede ayudar de forma práctica en:

- Criterios de uso: qué tipo de información puede tratarse en una reunión grabada/transcrita y cuál no debería salir de entornos controlados.

- Contención: si se ha compartido un enlace o se sospecha de acceso indebido, guiar los pasos para limitar daños (retirar permisos, revocar compartición, revisar accesos).

- Recuperación: apoyo cuando hay cuentas comprometidas, sesiones abiertas o pérdida/robo de dispositivo que afecta a reuniones y actas.

- Alternativas seguras: orientar hacia herramientas y configuraciones compatibles con el entorno universitario.

Lo que ha cambiado en 2025–2026

Hay tres cambios de fondo que explican por qué este tema es más importante ahora:

- “Bots” de reunión y agentes de IA: ya no es solo “grabar”, sino delegar en un servicio externo que entra en la reunión, captura contenido y lo procesa.

- Más datos derivados: además del audio/texto, se generan tareas, prioridades, etiquetas y “conclusiones”. Eso puede amplificar errores (resúmenes inexactos) y crear nuevos documentos que circulan.

- Mayor foco regulatorio y de gobernanza: las autoridades europeas han reforzado orientaciones sobre tratamiento de datos y sobre transferencias internacionales; en IA, también se insiste en limitar usos no compatibles y en asegurar base legal y garantías [EDPB, 2024; EDPS, 2025].

Por qué estas apps no están autorizadas con cuentas @comillas.edu y @alu.comillas.edu

Cuando una aplicación de terceros pide que inicies sesión con tu cuenta institucional o que le des acceso a calendario/correo/reuniones, no es un detalle técnico: es una decisión de tratamiento de datos. En general, la Universidad no autoriza conectar cuentas institucionales a herramientas de actas/transcripción/resumen en la nube que no hayan sido evaluadas y contratadas, por motivos como estos:

- Confidencialidad y minimización: una reunión universitaria puede contener datos personales y contenido sensible por contexto. Subir el audio/transcripción a un tercero suele exceder lo necesario para “tomar notas”.

- Relación contractual y responsabilidades: para que un proveedor trate datos personales de la Universidad, se necesita un marco adecuado (condiciones de encargado, obligaciones, subencargados, medidas, notificación de brechas, etc.) [EDPB, 2021]. En apps “auto-servicio” esto no está garantizado.

- Transferencias internacionales: si hay procesamiento o acceso desde fuera del EEE/UE, hay que cumplir las condiciones del Capítulo V del RGPD y disponer de garantías apropiadas [AEPD, 2026; EDPB, 2025]. En muchas herramientas, el flujo real de datos (y subproveedores) no es transparente para un usuario final.

- Riesgo de recogida excesiva y monetización: en servicios gratuitos, es frecuente que el “pago” sea la recopilación de datos y metadatos (uso, interacciones, integraciones), lo que puede chocar con el principio de minimización y con expectativas razonables de privacidad en un contexto universitario.

- Gobernanza y auditoría: si cada persona activa un proveedor distinto, se pierde trazabilidad: dónde están las actas, cuánto se conservan, quién accede, cómo se revoca, cómo se responde ante un incidente o una solicitud de derechos.

La consecuencia práctica es sencilla: aunque la herramienta sea cómoda, conectar una cuenta institucional a un tercero no evaluado puede exponer datos de estudiantes, personal y proyectos, y complicar seriamente el cumplimiento del RGPD y la gestión de incidentes.

Datos recientes en contexto

Para situar el riesgo sin alarmismo, conviene mirar tendencias generales (benchmarks). En el informe DBIR 2025 de Verizon, se indica que hubo implicación de terceros en el 30% de las brechas analizadas, lo que subraya que “lo externo” ya no es un caso raro cuando dependemos de proveedores y servicios conectados [Verizon, 2025].

El mismo informe destaca que, dentro del patrón de ataques a aplicaciones web, aproximadamente el 88% de las brechas notificadas en ese patrón implicaron el uso de credenciales robadas [Verizon, 2025]. En herramientas de reuniones y actas, donde el acceso suele estar “a un clic” en una cuenta en la nube, esto refuerza la importancia de reducir exposición y de no dispersar datos en múltiples servicios.

Por su parte, ENISA señala que la adopción de IA generativa avanza, pero que la gobernanza no siempre acompaña: en su Threat Landscape 2024 se menciona que solo un 21% de las organizaciones emplean políticas de uso de IA generativa; y que un 38% mitigan sus riesgos de ciberseguridad asociados, mientras que un 28% mitigan los riesgos de cumplimiento [ENISA, 2024]. Esto encaja con lo que vemos en el día a día: herramientas que se adoptan por productividad antes de aclarar privacidad, residencia de datos y control de accesos.

Nota: estos datos son referencias generales (benchmarks). Pueden variar por sector, tamaño y metodología, pero ayudan a entender por qué conviene reducir dependencias no evaluadas.

Checklist en 30 segundos

- Pregunta “¿necesitamos grabar?” Porque la mejor forma de proteger un dato es no crearlo si no hace falta.

- Si hay acta, prioriza “acta mínima”. Porque una acta no necesita transcripción literal con detalles personales.

- Evita mencionar en voz alta datos innecesarios. Porque una transcripción puede capturar nombres, números y contextos que luego circulan.

- No admitas bots/participantes desconocidos. Porque pueden ser servicios de terceros capturando la reunión sin evaluación.

- Desconfía de herramientas que piden acceso a correo y calendario “para resumir”. Porque amplían el alcance del tratamiento más allá de la reunión.

- Revisa permisos antes de compartir un resumen. Porque “cualquiera con el enlace” es una fuga habitual por prisa.

- Define destinatarios concretos y caducidad. Porque reduce la exposición si el enlace se reenvía.

- Separa lo académico/gestión de lo “personal”. Porque mezclar ámbitos en la misma herramienta complica privacidad y cumplimiento.

- Si dudas, no conectes tu cuenta @comillas.edu / @alu.comillas.edu a un tercero. Porque una autorización puede abrir acceso a más datos de los que imaginas.

- Ante cualquier señal rara, para y pide ayuda. Porque actuar rápido suele reducir impacto.

Qué hacer si ya ha pasado (sin tecnicismos)

- Si se compartió un enlace, retira el acceso cuanto antes. Cambia permisos a “solo personas concretas” y elimina accesos abiertos.

- Si entró un bot o un tercero, documenta lo mínimo. Anota fecha, nombre mostrado y qué se compartió (audio, transcripción, resumen).

- Si se usó una app con tu cuenta institucional, revoca permisos. Revisa qué aplicaciones tienen acceso y elimina las no necesarias.

- Si crees que hubo acceso indebido, cambia tu contraseña y revisa sesiones. Especialmente si recibiste avisos de inicio de sesión o notificaciones extrañas.

- No borres “a lo loco” si hay indicios de incidente. A veces conviene conservar evidencias mínimas para entender qué ocurrió y acotar.

- Avísanos pronto. Cuanto antes se actúe, más fácil es limitar el alcance (enlaces, permisos, recuperación).

Privacidad y trato respetuoso

La seguridad de la información y el RGPD no van de “culpas”. Van de evitar que, por prisa o por comodidad, se exponga información que afecta a otras personas o a la Universidad. En reuniones, además, es normal que se diga algo de más: por eso conviene diseñar el proceso para que el riesgo sea bajo incluso cuando vamos con el tiempo justo.

Si se detecta un uso no autorizado o una compartición indebida, el enfoque debe ser proporcional: cortar la exposición, entender el alcance y aprender para que no se repita. Y hacerlo cuidando la confidencialidad de quienes se han visto implicados.

Para finalizar

Las videollamadas con transcripción y actas generadas por IA son útiles, pero convierten la conversación en datos persistentes que pueden viajar a terceros, multiplicar la superficie de exposición y abrir problemas de RGPD, especialmente si hay transferencias fuera de la UE o falta de garantías contractuales [AEPD, 2026; EDPB, 2025].

En un entorno universitario, donde una reunión puede tocar expedientes, tutorías, investigación o gestión, la regla práctica es sencilla: minimiza (crea menos datos), controla (permite acceso solo a quien toca) y no conectes tu cuenta institucional a herramientas no evaluadas. Si ya ha pasado, lo mejor es parar, verificar y pedir ayuda.

Frase para recordar:

Si una reunión “se convierte en archivo”, trátala como un dato confidencial y potencialmente sensible, y En ese caso, debe cifrarse.